Recherche : Stopper le h-index

Utiliser le h-index dans l’évaluation de la recherche ? Cela ne vaut mieux pas. Mais pourquoi pas en fait ? Pourquoi l’utilisation de cet indicateur est-elle si problématique ? Et quelles sont les alternatives ? Les auteurs vous présentent une infographie qui répond à ces questions et vise à mettre en lumière certains points clés de cette discussion

par Sarah de Rijcke, Professor of Science, Technology, and Innovation Studies, Ludo Waltman, Professor of Qauntitative Science Studies, Thed van Leeuwen, Professor by special appointment Science Studies – Leiden University

publication originale : 19 mai 2021

Parfois, faire passer un message nécessite une approche plus visuelle. C’est pourquoi nous avons récemment fait équipe avec un graphiste pour créer une infographie sur le h-index ou plutôt, sur les raisons de ne pas utiliser le h-index.

D’après notre expérience avec les parties prenantes de l’évaluation de la recherche, les débats sur l’utilité de l’indice h ne cessent de surgir. Cela se produit même dans des contextes plus favorables à l’évaluation responsable de la recherche. Bien sûr, l’indice h est bien connu, tout comme ses inconvénients. Pourtant, les diverses questions qui s’y rapportent ne semblent pas encore être connues de tous. Dans le même temps, les développements actuels en matière d’évaluation de la recherche proposent des approches plus holistiques. Parmi les exemples, citons l’enquête évaluative développée dans notre propre centre, ainsi que les approches visant à évaluer les institutions universitaires dans leur contexte. En ce qui concerne la création d’indicateurs proprement dite, une meilleure contextualisation a été demandée, exigeant de les dériver « en milieu naturel » et non de manière isolée.

L’évolution vers des approches d’évaluation de la recherche plus complètes, qui prennent en compte la recherche dans toutes ses variantes, est également soutenue par l’ensemble de la communauté des évaluateurs de la recherche, ce qui constitue un argument convaincant en faveur de l’abandon d’un raisonnement fondé sur un seul indicateur.

Pourtant, certains s’opposent à ce que l’on reconsidère l’utilisation des indicateurs. Lorsque l’infographie a été présentée pour la première fois sur Twitter, elle a suscité des réponses mettant en cause l’utilisation abusive de l’indice h dans la pratique, dénigrant les évaluations plus qualitatives ou rejetant tout simplement la responsabilité de prendre des mesures en raison d’un manque perçu d’alternatives. Cela montre qu’il est effectivement nécessaire de réexaminer l’indice h.

h-index and carrières des chercheurs

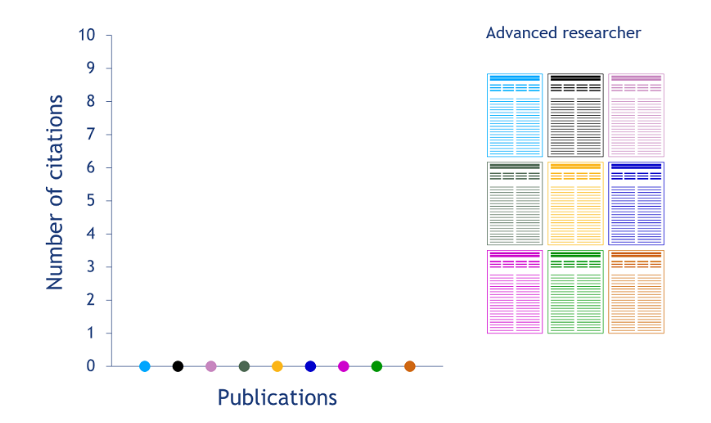

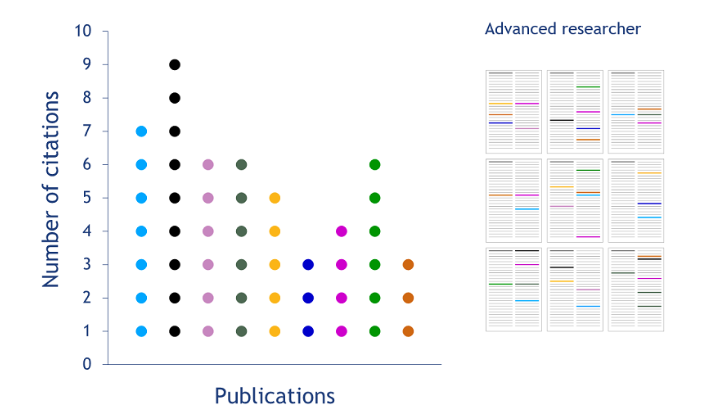

Au fil du temps, les publications représentées attirent de plus en plus de citations (voir l’axe des ordonnées dans la figure 2).

représentations colorées des citations reçues telles qu’elles apparaissent dans d’autres publications.

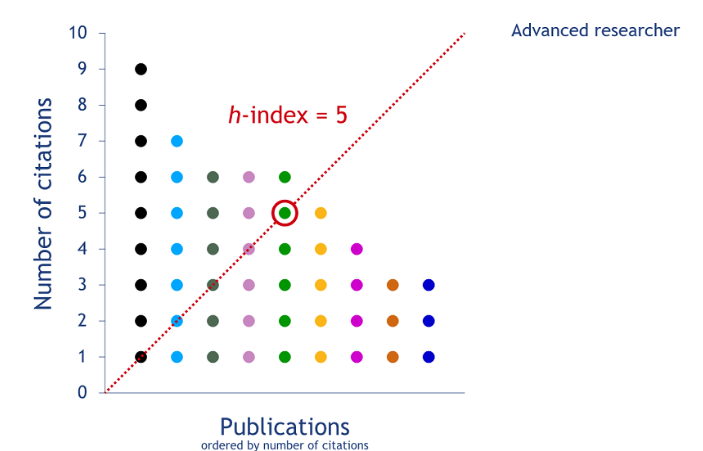

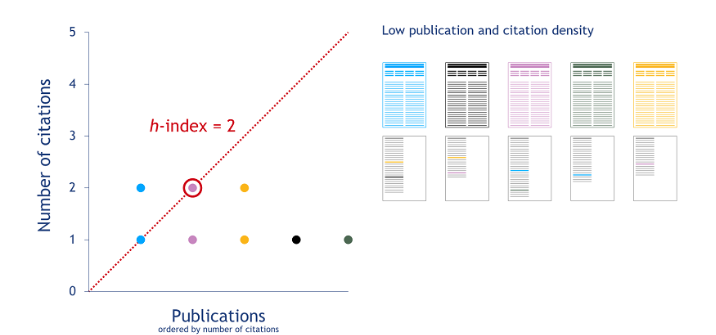

Si l’on classe la liste des publications d’un chercheur en fonction du nombre (décroissant) de citations reçues par chacune d’entre elles, on obtient une distribution telle que celle de la figure 3. La valeur du h-index h est égale au nombre de publications (N) qui ont reçu N citations ou plus. Dans notre exemple, cela donne un h-index de cinq.

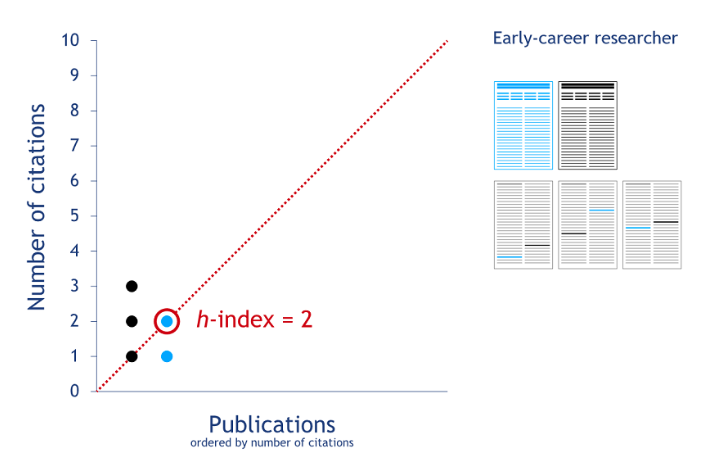

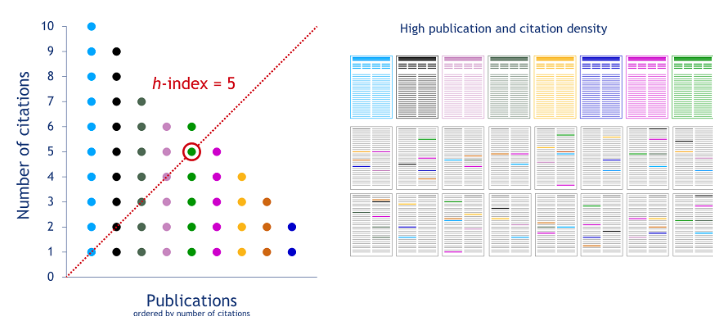

La situation est moins favorable pour les chercheurs en début de carrière. En effet, le h-index ne tient pas compte de l’âge académique : avec cette métrique, les chercheurs qui sont là depuis moins longtemps obtiennent de moins bons résultats. Par conséquent, si le h-index fournit une indication sur le stade de carrière d’un chercheur, il ne permet pas de comparer équitablement des chercheurs se trouvant à des stades de carrière différents.

h-index and carrières des chercheurs

Un autre problème du h-index est qu’il ne tient pas compte des différences dans les pratiques de publication et de citation entre les domaines et même à l’intérieur de ceux-ci. Un examen plus approfondi d’un autre cas hypothétique permet d’illustrer ce problème. Nous examinons deux domaines scientifiques différents : L’un avec une faible densité de publications et de citations (figure 5) et l’autre avec une forte densité de publications et de citations (figure 6). Le chercheur dans le domaine à faible densité de publications et de citations a un h-index de deux, tandis que le h-index est égal à cinq pour le chercheur dans le domaine à forte densité de publications et de citations. La différence entre les h-index des deux chercheurs ne reflète pas une différence de performances scientifiques. Elle résulte simplement des différences dans les pratiques de publication et de citation entre les domaines dans lesquels les deux chercheurs sont actifs.

Trois problèmes relatifs au h-index

L’application du h-index dans l’évaluation de la recherche nécessite également une évaluation critique. Trois cas problématiques peuvent être identifiés en particulier (figure 7). Le premier, dans lequel le h-index facilite les comparaisons injustes entre les chercheurs, a déjà été discuté.

facilite des comparaisons inéquitables

récompense de mauvaises publications et un comportement de référencement

rend importantes des contributions invisibles

Le h-index favorise les chercheurs qui sont actifs depuis plus longtemps. Il favorise également les chercheurs qui travaillent dans des domaines où la densité de publications et de citations est plus élevée (figure 8).

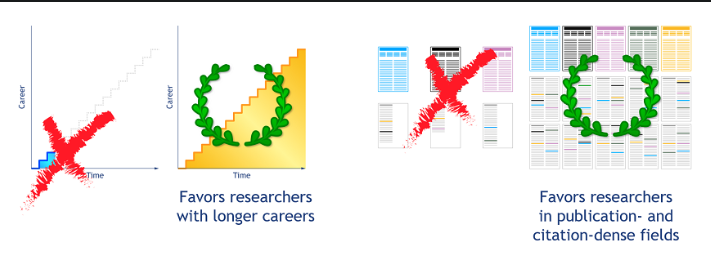

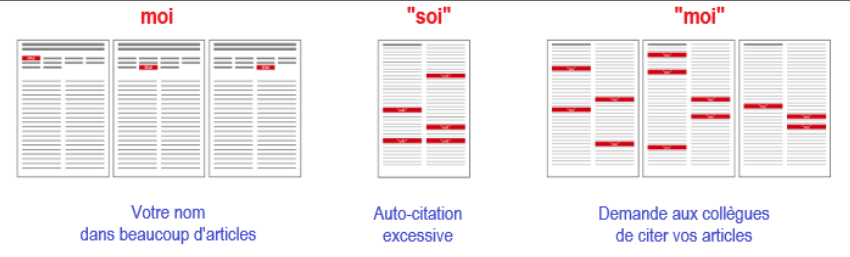

Un autre problème du h-index est que le fait de publier beaucoup devient une « vertu » en soi. Cela signifie que les chercheurs ont intérêt à faire figurer leur nom sur le plus grand nombre possible de publications. Cela peut conduire à un comportement indésirable en matière d’autorat (figure 9). De même, l’accent mis par le h-index sur les citations peut entraîner des pratiques douteuses en matière de citations.

Il existe encore un autre problème. En mettant tellement l’accent sur les publications, le h-index réduit l’évaluation de la recherche à un seul type d’activité académique. Cela va à l’encontre des efforts déployés pour mettre en place un système d’évaluation plus responsable qui prenne également en compte d’autres types d’activités académiques : leadership, vision, collaboration, enseignement, compétences cliniques ou contributions à un groupe de recherche ou à une institution (figure 10).

Se fier à un seul indicateur est une vision à court terme, exposant au risque d’avoir des effets réducteurs considérables. La diversité thématique risque d’en pâtir puisque, comme nous l’avons vu plus haut, certains domaines scientifiques sont favorisés par rapport à d’autres. En outre, un système de recherche sain nécessite divers types de talents et de dirigeants, ce qui signifie que les chercheurs doivent être évalués d’une manière qui rende justice à la grande diversité des activités universitaires, plutôt que sur la seule base de mesures de la production de publications et de l’impact des citations.

Stopper le h-index et utiliser des approches alternatives pour évaluer les chercheurs

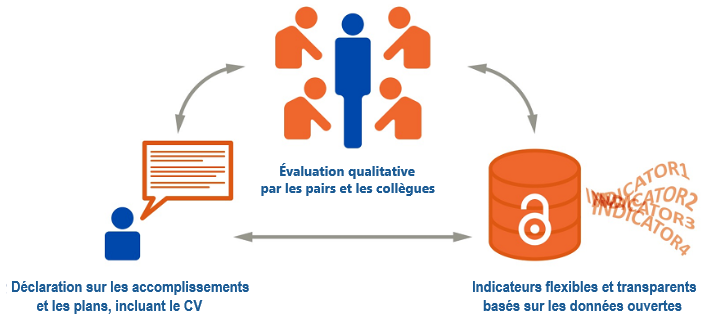

Comment alors « stopper le h-index » ? Nous souhaiterions mettre l’accent sur une triple approche lorsqu’il s’agit d’évaluer les universitaires (figure 11). Le point de départ est une évaluation qualitative par les pairs et les collègues. En outre, les indicateurs utilisés pour l’évaluation doivent être à la fois transparents et flexibles. La transparence signifie que le calcul d’un indicateur est clairement documenté et que les données qui le sous-tendent sont divulguées et rendues accessibles. Les indicateurs de type « boîte noire » ne sont donc pas acceptables. En ce qui concerne la flexibilité, l’évaluation ne doit pas appliquer une approche unique. Elle devrait plutôt s’adapter au type de travail effectué par un chercheur et au contexte spécifique de l’organisation ou du domaine scientifique dans lequel le chercheur est actif. Enfin, nous pensons que les justifications écrites, par exemple les récits ou les déclarations personnelles, devraient devenir un élément important des évaluations, y compris dans le contexte des promotions ou des demandes de subventions. Ces déclarations pourraient par exemple mettre en évidence les principales réalisations des chercheurs et leurs plans pour l’avenir.

En conclusion, l’évaluation des chercheurs individuels doit être considérée comme un processus qualitatif mené par pairs et collègues. Ce processus peut être soutenu par des indicateurs quantitatifs et des formes qualitatives d’information qui, ensemble, couvrent les diverses activités et rôles des chercheurs. L’utilisation d’un seul indicateur non représentatif, voire inéquitables dans de nombreux cas et basé sur le nombre de publications et de citations n’est pas acceptable.

Cette conclusion est tout à fait conforme aux appels en faveur d’approches plus larges de la reconnaissance et des récompenses dans le monde universitaire, et a également été spécifiée dans le manifeste de Leiden :

« Lire et juger le travail d’un chercheur est beaucoup plus approprié que de se fier à un seul chiffre. Même lorsqu’il s’agit de comparer un grand nombre de chercheurs, il est préférable d’adopter une approche qui prenne en compte davantage d’informations sur l’expertise, l’expérience, les activités et l’influence d’une personne. » (Principe 7 du Manifeste de Leiden)

Texte original sous licence CC BY 4.0 – Texte et infographies traduit par la Rédaction, soumis aux droits d’auteur.

Photo d’en-tête : Mwabonje Ringa

Science infuse est un service de presse en ligne agréé (n° 0329 X 94873) piloté par Citizen4Science, association à but non lucratif d’information et de médiation scientifique.

Non subventionné, notre média dépend entièrement de ses contributeurs pour continuer à informer, analyser, avec un angle souvent différent car farouchement indépendant. Pour nous soutenir, et soutenir la presse indépendante et sa pluralité, faites un don pour que notre section site d’actualité et d’analyse reste d’accès gratuit !

avec J’aime l’Info, partenaire de la presse en ligne indépendante