Utilisation de l’intelligence artificielle (IA) par les journalistes et rédactions : le Conseil de déontologie journalistique et de médiation (CDJM) publie un guide de bonnes pratiques

C’est une nouvelle recommandation, la quatrième, que l’organisme consultatif publie en date du 14 juillet sur un sujet brûlant face au déploiement très rapide de l’intelligence artificielle dans un contexte qui reste « nouveau et incertain ». Le champ d’application est potentiellement vaste, touchant des aspects sociétaux, techniques, financiers et démocratiques, mais comme toujours il est circonscrit par le CDJM à sa mission : la déontologie journalistique

Nous avons présenté et commenté les diverses recommandations thématiques du Conseil de déontologie journalistique au moyen desquelles le CDJM tente de dresser un référentiel français de façon bien utile en matière de journalisme. Fidèle à cette tradition dans nos colonnes, voici une vue d’ensemble de cette nouvelle ligne directrice.

Le sujet, c’est que jusqu’ici, l’intelligence artificielle aidait les journalistes et rédactions dans leur travail, mais qu’aujourd’hui, elle est capable de faire le travail à leur place, ce qui peut être abusif, malintentionné, avec tous les risques de mésinformation que l’on connaît, et trompeur pour le public qui croit légitimement avoir à faire à des journalistes professionnels humains. Le CDJM à ce titre voit 2022 comme une année charnière avec l’arrivée brutale d’outils de générations d’image comme Midjourney qui crée des visuels très réalistes à partir de descriptions au format texte. Et bien sûr, pour la partie éditoriale, le lancement de ChatGPT, agent conversationnel (chatbot) d’OpenAI à base de grands modèles de langage (LLM). Depuis lors, l’engouement est certain et la concurrence fait rage.

Pour les défis éthiques et particulièrement la déontologie journalistique, le CDJM a souhaité établir les principes de « chartes de référence » comme rempart, dont certaines sont anciennes, afin de dessiner les contours de ce que l’on peut faire ou ne pas faire au moyen de l’intelligence artificielle en matière journalistique, et selon quelles modalités.

Pour classer les usages et les recommandations, l’organisme a utilisé le référentiel de gestion des risques de l’Union européenne qui effectue un classement selon trois grands niveaux de risque des pratiques.

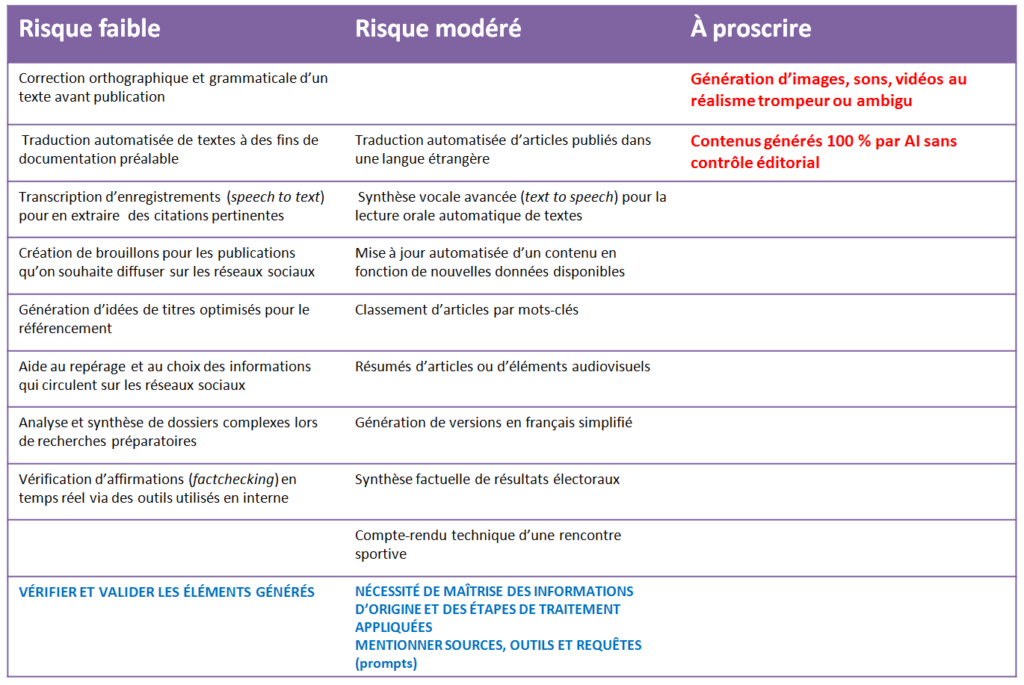

Nous vous proposons une synthèse des pratiques et de leur classement dans le guide du CDJM sous forme de tableau :

Il s’agit ici d’exemples non exhaustifs proposés par le CDJM pour les 3 niveaux de risque, le troisième sur la droite étant bien évidemment le plus élevé, intolérable puisque les actions considérées sont à proscrire.

Sous les exemples, en dernière ligne (majuscules, bleu) apparaissent les recommandations formulées pour chaque catégorie de risques.

On constate que les exemples d’actions pour la catégorie à risque faible sont des traitements par outils d’AI à usage interne (pas à visée de publication ou diffusion du résultat du traitement par l’IA), hormis les correcteurs orthographiques et grammaticaux. La recommandation est de vérifier et valider tous les éléments générés par des outils d’AI.

Pour la catégorie à risque modéré, on constate l’utilisation d’outils d’AI qui génèrent directement au moins une partie des contenus publiés. Dans ce cas la recommandation et la maîtrise des informations sources et du traitement appliqué, par le journaliste en charge, afin de garantir la pertinence éditoriale, ainsi que la transparence vis-à-vis du public en citant les outils d’AI utilisés. Le CDJM insiste également sur la nécessité d’informer le public de toute image synthétique (« dessins, illustrations, vue d’artiste, reconstitutions,… ») avec une légende indiquant : « image générée par une AI ».

Pour ce qui est de la conception ou de la configuration des outils d’IA, les journalistes et éditeurs doivent être impliqués, recommande le CDJM.

Il met aussi en garde sur les outils d’expérience de navigation personnalisée pour le public, du « sur-mesure » qui ne doit jamais être « en conflit avec la ligne éditoriale et les choix rédactionnels effectués dans le traitement de l’actualité. »

Remarque sur les outils de traduction

Nous nous permettons une remarque sur l’utilisation de la traduction pour la publication d’articles : il aurait été utile selon nous que le CDJM rappelle que la traduction est un métier et qu’un traducteur automatique est un outil d’IA qui ne remplace pas le professionnel de la traduction. Le journaliste n’est pas un traducteur, mais on en trouve quelques traducteurs dans certaines rédactions (rédacteur-traducteur, assimilé journaliste). C’est ainsi que tout article traduit automatique visant à être publié devrait être examiné et corrigé par un traducteur professionnel (journaliste ou non).

Utilisations proscrites : publication de faux et absence de contrôle

L’utilisation de l’intelligence artificielle ne doit pas tromper le public ou le faire s’interroger par l’ambiguïté provoqués par des images, des sons ou des vidéos à fort degré de réalisme, puisque cela porte une information contraire à la réalité des faits. D’ailleurs, le CDJM en profite pour rappeler que la publication de faux est une faute déontologique majeure, avec ou sans implication d’IA. Il rappelle qu’une mention en crédit n’est pas suffisante pour évoquer l’outil d’IA utilisé, il faut être explicite et faire en sorte que l’information sur l’élément artificiel ne puisse échapper au public, et cela peut intervenir quand le sujet de la publication est précisément la création et la circulation de fausses images.

Le second aspect de pratique proscrite est la diffusion sans contrôle de contenus générés intégralement par des outils d’IA : le contrôle éditorial est obligatoire, sous la supervision de journalistes, à toutes les étapes de production, relecture et validation, comme pour tout autre contenu.

Qualité des requêtes, valorisation du photojournalisme

Le CDJM insiste sur la nécessité de rédactions proactives, notamment en ce qui concerne l’utilisation de robots conversationnels comme ChatGPT, rappelant que la qualité des textes générés peut être problématique. Il insiste sur la qualité des requêtes qui a un impact sur les contenus générés par ces outils d’IA. Il convient donc de former les journalistes à la création de requêtes (les prompts), et aussi établir des règles internes à leur usage (prompt engineering).

Le CDJM propose aussi de privilégier le réel pour les images en valorisant les photojournalistes, conscient que les fausses images participent à la confusion du public entre ce qui est vrai et ce qui est faux. Les légendes et mentions spécifiques requises comme décrit plus haut dans les recommandations peuvent bien sûr aider à faire la différence, ce qui est crucial.

En conclusion, il insiste sur la nécessité de former les journalistes et rédactions aux outils d’IA mais aussi de les impliquer dans leur conception.

Pour aller plus loin

Science infuse est un service de presse en ligne agréé (n° 0324 x 94873) piloté par Citizen4Science, association à but non lucratif d’information et de médiation scientifique doté d’une Rédaction avec journalistes professionnels. Nous défendons farouchement notre indépendance. Nous existons grâce à vous, lecteurs. Pour nous soutenir, faites un don ponctuel ou mensuel.

ou via J’aime l’Info, partenaire de la presse en ligne indépendante