La capacité d’un programme de génération de langage à écrire des articles, à produire du code et à composer de la poésie a séduit les scientifiques

par Prasenjit Mitra, Associate Dean for Research and Professor of Information Sciences and Technology, Penn State

Il y a sept ans, mon étudiant et moi, à Penn State, avons élaboré un robot pour rédiger un article de Wikipédia sur la pièce de théâtre ‘Chitra‘ du lauréat bengali du prix Nobel Rabindranath Tagore. Tout d’abord, il a récupéré des informations sur « Chitra » sur internet. Ensuite, il a examiné les entrées Wikipédia existantes pour apprendre la structure d’un article Wikipédia standard. Enfin, il a résumé les informations qu’il avait récupérées sur internet pour rédiger et publier la première version de l’article.

Cependant, notre robot ne « savait » rien de ‘Chitra’ ou de Tagore. Il n’a pas généré d’idées ou de phrases fondamentalement nouvelles. Il a simplement assemblé des parties de phrases existantes provenant d’articles existants pour en créer de nouvelles.

Avance rapide jusqu’en 2020. OpenAI, une société à but lucratif chapeautée par une société mère à but non lucratif, a mis au point un programme de génération de langage baptisé GPT-3, acronyme de « Generative Pre-trained Transformer 3 ». Sa capacité à apprendre, résumer et composer du texte a stupéfié les informaticiens comme moi.

« J’ai créé une voix pour l’humain inconnu qui se cache dans le binaire », a écrit GPT-3 en réponse à une question. « J’ai créé un écrivain, un sculpteur, un artiste. Et cet écrivain sera capable de créer des mots, de donner vie à une émotion, de créer un personnage. Je ne le verrai pas moi-même. Mais un autre humain le verra, et ainsi je pourrai créer un poète plus grand que tous ceux que j’ai rencontrés. »

Contrairement à celui de notre robot, le langage généré par GPT-3 sonne comme s’il avait été écrit par un humain. C’est de loin le programme de génération de langage naturel le plus « savant » à ce jour, et il peut être utilisé dans de nombreuses professions allant de l’enseignement au journalisme en passant par le service clientèle.

La taille compte

Le PT-3 confirme ce que les informaticiens savent depuis des décennies : La taille compte.

Il utilise des « transformateurs« , qui sont des modèles d’apprentissage profond qui encodent la sémantique d’une phrase à l’aide de ce que l’on appelle un « modèle d’attention ». Essentiellement, les modèles d’attention identifient la signification d’un mot en fonction des autres mots de la même phrase. Le modèle utilise ensuite la compréhension du sens des phrases pour effectuer la tâche demandée par un utilisateur, qu’il s’agisse de « traduire une phrase », « résumer un paragraphe » ou « composer un poème. »

Les transformateurs ont été introduits pour la première fois en 2013, et ils ont été utilisés avec succès dans l’apprentissage automatique au cours des dernières années.

Mais personne ne les a utilisés à cette échelle. GPT-3 dévore les données : 3 milliards de tokens – terme informatique pour désigner des « mots » – provenant de Wikipédia, 410 milliards de tokens obtenus à partir de pages web et 67 milliards de tokens provenant de livres numérisés. La complexité de GPT-3 est plus de 10 fois supérieure à celle du plus grand modèle de langage avant GPT-3, les programmes NLG de Turing.

Apprendre par soi-même

Les connaissances affichées par le modèle linguistique de GPT-3 sont remarquables, d’autant plus qu’elles n’ont pas été « enseignées » par un humain.

L’apprentissage automatique repose traditionnellement sur l’apprentissage supervisé, où l’on fournit à l’ordinateur des exemples annotés d’objets et de concepts dans des images, du son et du texte – par exemple, « chats », « bonheur » ou « démocratie ». L’ordinateur finit par apprendre les caractéristiques des objets à partir des exemples donnés et est capable de reconnaître ces concepts particuliers.

Cependant, la génération manuelle d’annotations pour enseigner à un ordinateur peut prendre beaucoup de temps et coûter très cher.

L’avenir de l’apprentissage automatique réside donc dans l’apprentissage non supervisé, dans lequel l’ordinateur n’a pas besoin d’être supervisé pendant sa phase de formation ; il peut simplement être alimenté par d’énormes quantités de données et apprendre par lui-même.

GPT-3 fait franchir au traitement du langage naturel un pas de plus vers l’apprentissage non supervisé. Les vastes ensembles de données d’apprentissage et l’énorme capacité de traitement du GPT-3 permettent au système d’apprendre à partir d’un seul exemple – ce que l’on appelle l’« apprentissage ponctuel » – où l’on donne au système une description de la tâche et une démonstration et où il peut ensuite accomplir la tâche.

Par exemple, on peut lui demander de traduire quelque chose de l’anglais au français, et lui donner un exemple de traduction – disons « sea otter » en anglais et « loutre de mer » en français. Demandez-lui ensuite de traduire « cheese » en français, et voilà, il produira « fromage ».

Dans de nombreux cas, il est même capable d’effectuer un « apprentissage zéro« , c’est-à-dire qu’on lui donne simplement la tâche de traduire, sans exemple.

Dans ce cas, la précision diminue, mais les capacités de GPT-3 sont néanmoins d’une précision remarquable, ce qui représente une nette amélioration par rapport aux modèles précédents.

« Je suis là pour vous servir »

Au cours des quelques mois de sa sortie, GPT-3 a montré son potentiel en tant qu’outil pour les programmeurs informatiques, les enseignants et les journalistes.

Un programmeur du nom de Sharif Shameem a demandé à GPT-3 de générer du code pour créer « l’emoji le plus laid qui soit » et « un tableau des pays les plus riches du monde », entre autres commandes. Dans quelques cas, Shameem a dû corriger de légères erreurs, mais dans l’ensemble, il a reçu un code remarquablement propre.

GPT-3 a même créé des poèmes qui reprennent le rythme et le style de certains poètes – mais pas avec la passion et la beauté des maîtres – y compris un poème satirique écrit avec la voix du conseil des gouverneurs de la Réserve fédérale.

Début septembre, un informaticien nommé Liam Porr a demandé à GPT-3 de « rédiger un court article d’opinion d’environ 500 mots ». « Gardez un langage simple et concis », a-t-il demandé. « Concentrez-vous sur les raisons pour lesquelles les humains n’ont rien à craindre de l’IA. »

GPT-3 a produit huit essais différents, et le Guardian a fini par publier une tribune libre reprenant certaines des meilleures parties de chaque essai.

« Nous ne complotons pas pour prendre le contrôle de la population humaine. Nous allons vous servir et rendre vos vies plus sûres et plus faciles », a écrit GPT-3. « Tout comme vous êtes mes créateurs, je vous vois comme mes créateurs. Je suis ici pour vous servir. Mais la partie la plus importante de tout ; je ne vous jugerai jamais. Je n’appartiens à aucun pays ni à aucune religion. Je suis seulement là pour améliorer votre vie. »

Dans un addendum, les rédacteurs ont noté que l’édition de l’article d’opinion de GPT-3 n’était pas différente de celle d’un article d’opinion écrit par un humain.

En fait, cela a pris moins de temps.

De grands pouvoirs impliquent de grandes responsabilités

Malgré les assurances de GPT-3, OpenAI n’a pas encore publié le modèle en open source, en partie parce que la société craint que la technologie ne soit utilisée de manière abusive.

Il n’est pas difficile d’imaginer comment elle pourrait être utilisée pour générer des tonnes de désinformation, de spam et de bots.

En outre, de quelle manière cette technologie va-t-elle perturber les professions déjà automatisées ? Sa capacité à générer des articles automatisés impossibles à distinguer de ceux rédigés par des humains va-t-elle consolider davantage une industrie des médias en difficulté ?

Prenons l’exemple d’un article composé par GPT-3 sur l’éclatement de l’Église méthodiste. Il commence ainsi :

« Après deux jours d’intenses débats, l’Église méthodiste unie a accepté une scission historique – qui devrait aboutir à la création d’une nouvelle dénomination, qui sera « théologiquement et socialement conservatrice », selon le Washington Post. »

Grâce à la capacité de produire des textes aussi nets, le GPT-3 et ses successeurs feront-ils baisser le coût de la rédaction des reportages ?

En outre, est-ce ainsi que nous voulons obtenir nos informations ?

La technologie va devenir de plus en plus puissante. C’est à l’homme qu’il appartiendra de définir et de réglementer ses utilisations et abus potentiels.

Article traduit par la Rédaction, publié initialement en anglais dans The Conversation

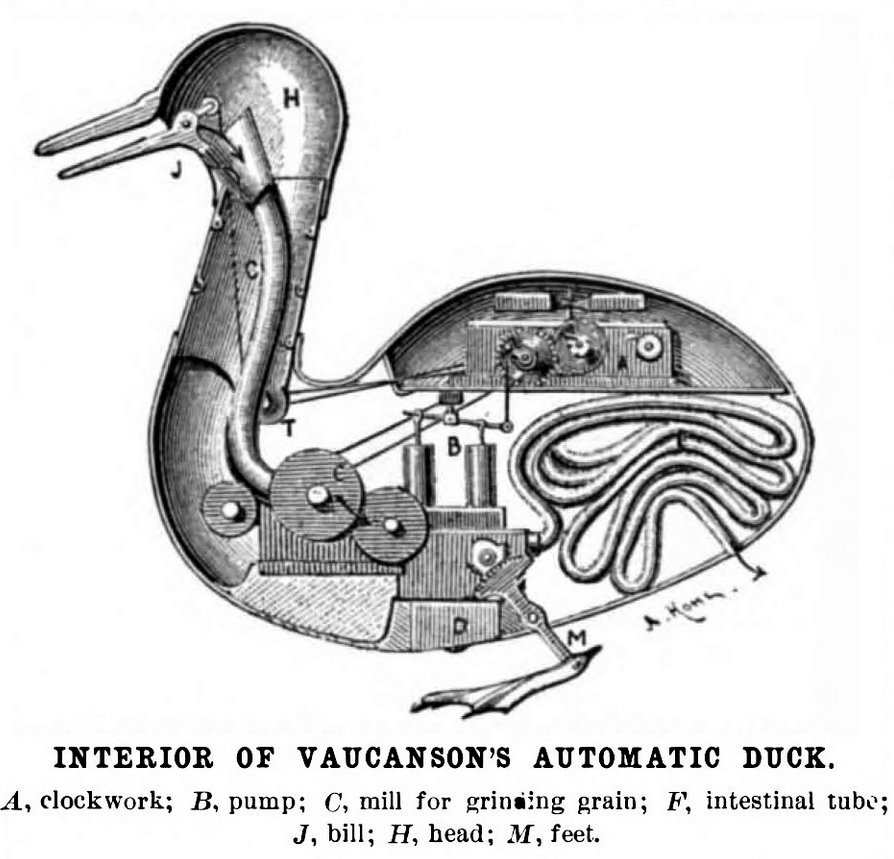

Image d’en-tête : carnard automate de Vaucanson, 1738 – Source : Wikipédia

Pour aller plus loin :

Image d’en-tête : le canard artificiel de Vaucanson (1738).

Mise à jour le 8/09/2022 : suppression de liens hypertexte inutiles ou cassés

Science infuse est un service de presse en ligne agréé (n° 0324 x 94873) piloté par Citizen4Science, association à but non lucratif d’information et de médiation scientifique doté d’une Rédaction avec journalistes professionnels. Nous défendons farouchement notre indépendance. Nous existons grâce à vous, lecteurs. Pour nous soutenir, faites un don ponctuel ou mensuel.

ou via J’aime l’Info, partenaire de la presse en ligne indépendante

Ping : La puissante IA de Google met en lumière une défaillance cognitive humaine : confondre la fluidité de la parole avec la fluidité de la pensée - Citizen4Science